Fine_Tuning

Fine_tuning practice

找点事做,算是。哎,道路曲折。

主机huggingface password iW7GHBpZ

现在基本上是使用一个预训练模型加上一个prompt 或者是fine tuning

transformer 一个生态系列 很多的库 Lora

使用的是miniconda

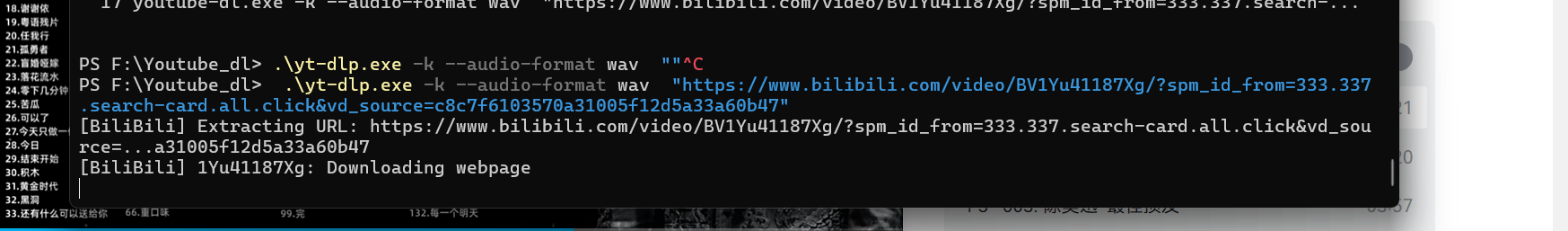

后运行job的指令 第一个就是末尾加& 第二个就是ctrl+z stop他和current job然后使用一个bg 指令 jobs 显示当前进行i的job 然后还有 fg指令前台化

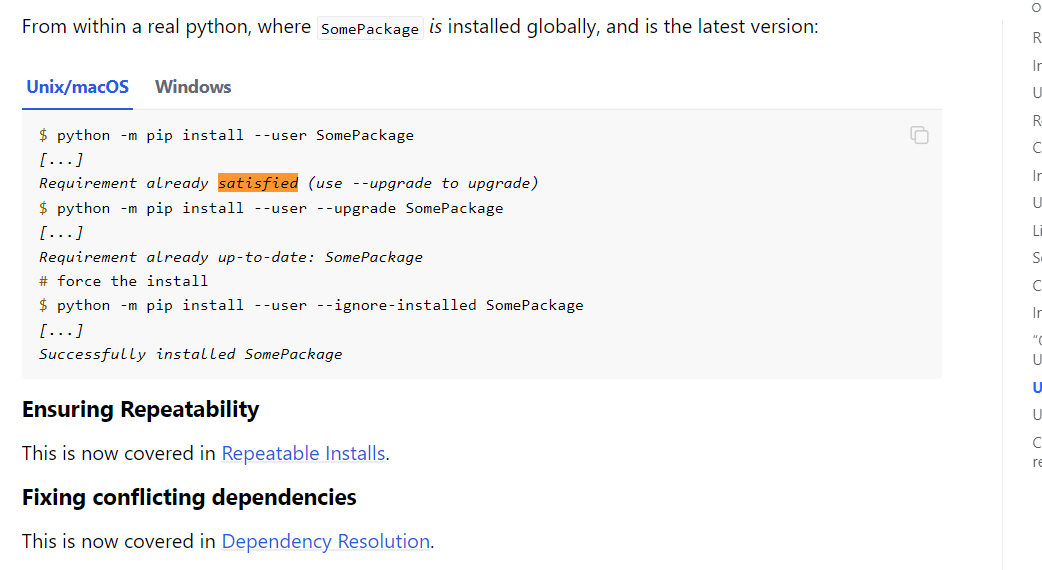

pip 或者整个虚拟环境的 一个原理就是每个包所具有的依赖都是存在于对应的包里面 然后下载的时候要确定对应的 解释器

离线下载就是下载好了文件 然后scp然后AutoModel.from_pretrained()里面写文件夹的名字

三个数据集合

training set 用于训练更新参数的

test set 用于最终评价的 不用于 改变参数

validation set 可以理解为中间的一个模拟测试 来反馈我们的超参数设置情况。

数据集的加载 使用的是dataset 这个包

数据集的划分 train_test_split 按照比例划分

选取 用 select 过滤用 filter加lamda 函数

预处理 使用map 方法 结合tokenizer

存放就是 load and save

加载本地文件 —— 可以直接加载整个文件夹 对

很多方法 殊途同归 然后可以自己写脚本来

tokenizer 中 inputs_id 就是转换后的唯一id attentino_mask 就是判断改数字是否是填充padding type——id就是确定这个句子是第几个。

显存优化

CSAPP LAB 3 attack lab

- Post title:Fine_Tuning

- Post author:Winter

- Create time:2024-03-25 16:32:02

- Post link:https://spikeihg.github.io/2024/03/25/Fine-Tuning/

- Copyright Notice:All articles in this blog are licensed under BY-NC-SA unless stating additionally.